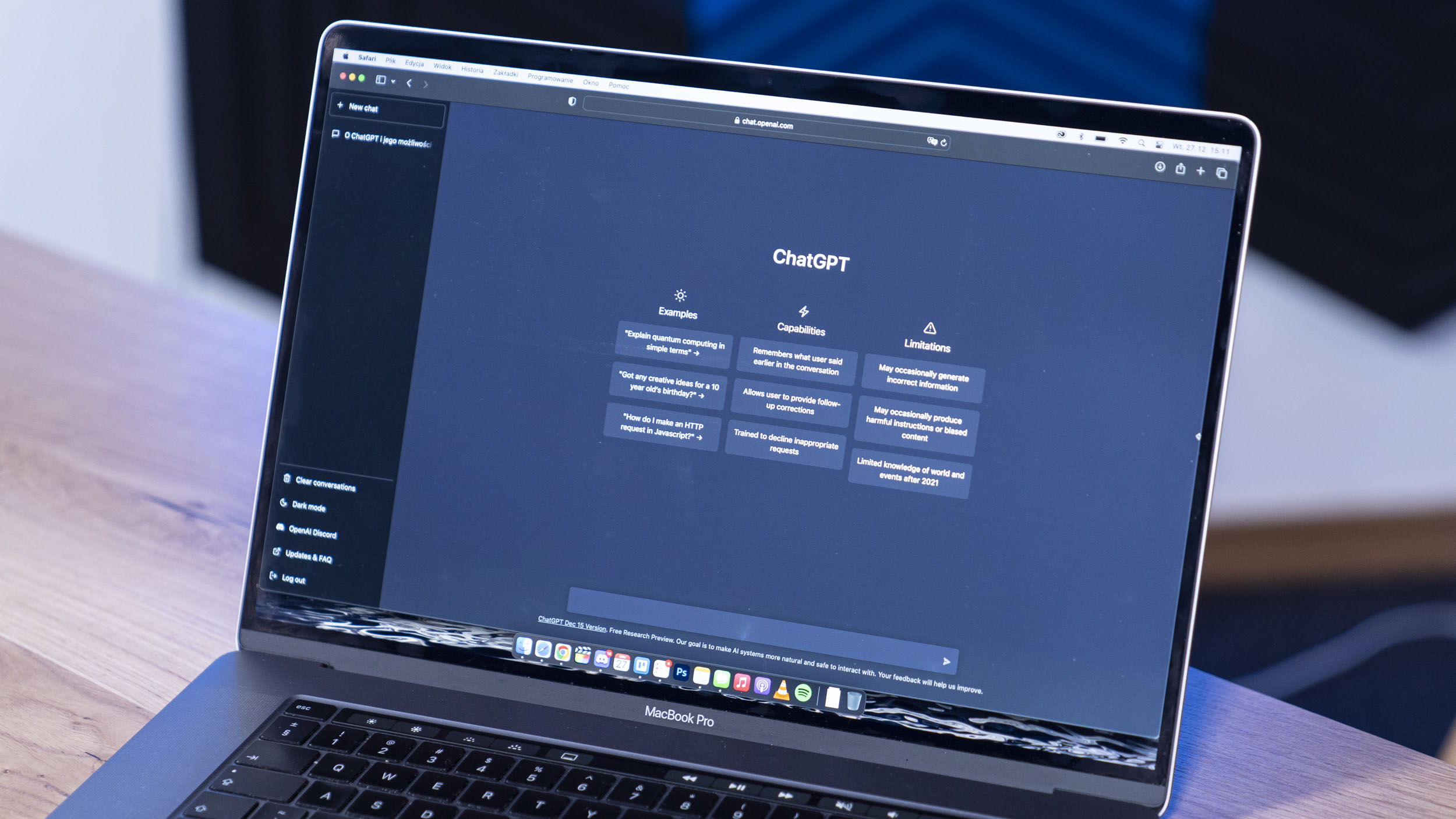

Ostatnio głośno jest w Internecie o ChatGPT, który jednych zachwyca, a u drugich wywołuje zmartwienie i wątpliwości. Poprosicie go o co tylko chcecie, esej, scenariusz do filmu, piosenkę czy wiersz – zrobi to w mgnieniu oka. Zyskał rzeszę fanów liczoną w milionach, ale też grono przeciwników. Ci obawiają się zastąpienia przez rozwijające się AI.

Nowy chatbot stworzony został w 2015 roku i opiera się na sztucznej inteligencji, więc może wciąż popełniać błędy. Baza danych, które wykorzystuje do tworzenia została pobierana z Internetu i „kończy się” w okolicach 2021 roku. A jak się pewnie domyślacie znalazło się tam wszystko, nawet to czego nie chcielibyście widzieć.

Rozwój za cenę traumy

O ile dostęp ChatGPT do skrawka treści z Internetu przerodził się w mały sukces, tak jest to również punkt zapalny. Internet jest przepełniony treściami wulgarnymi, rasistowskimi, seksualnymi, zawierającymi przemoc itp. Nic dziwnego, że te również dotarły do bazy danych.

Na podstawie przykładów AI miało odrzucać treści nieodpowiednie, ale najpierw musiało się “nauczyć” co jest złe. W tym celu zatrudniono moderatorów do sprawowania kontroli nad przepływającą treścią danych. OpenAI skorzystało z pomocy firmy zewnętrznej w Kenii, a zadanie polegało na przeglądaniu i selekcjonowaniu co jest nieodpowiednie dla algorytmu.

Tysiące skrawków tekstów ociekających przemocą wyjętych niczym z horroru było przeglądanych przez tych ludzi. Poskutkowało to ich przedwczesną rezygnacją z 8 miesięcznym wyprzedzeniem. Nic dziwnego, skoro mało kto po takiej dawce przemocy mógłby spać spokojnie. Trauma do końca życia murowana.

Pracownicy firmy Sama, którzy zostali powołani do tego wyniszczającego psychicznie zadania, byli osobami ubogimi, które miały szansę zdobyć pieniądze. Te nie były najwyższe, bo była to stawka zaledwie 2$ za godzinę tortur, których nikt im nie wynagrodzi.

Trzeba jednak dodać, że mogli w każdym momencie powiedzieć, że to dla nich za dużo i nie godzą się na tak brutalne warunki pracy. Nie byli przetrzymywani niewolniczo, ani zmuszani w żaden sposób.

Gdy nie ma się nic, to pieniądze są bardzo silną motywacją, żeby naginać swoje granice. Po wszystkim pracownicy mieli możliwość skorzystania z terapii grupowej, ale bez indywidualnego podejścia do traumy każdej z osób.

Jedynym plusem sytuacji wydaje się fakt, że ich wysiłek i poświęcenie nie poszły na marne. Stworzono narzędzia, które wykrywają toksyczne treści i wbudowano je w kod ChatGPT. Pytanie czy tak duży “koszt” był faktycznie niezbędny? Osoby korzystające z chatbota w przyszłości nie będą musiały się martwić o tworzone przez niego treści. Jednak cały ten ciężar spadł na pracowników w Kenii.

Krew, flaki i koszmary twórców Mortal Kombat

Cała ta sytuacja pokazuje, że sztuczna inteligencja potrzebuje przynajmniej na początku dużego wkładu ludzkiej pracy. Nic od początku nie jest idealne. Nie jest to pierwsze takie zdarzenie, gdy pracownicy są wystawiani na ekstremalne doznania podczas swojej pracy.

Gra Mortal Kombat znana jest z dużej ilości przemocy i krwii podczas wykonywania ciosów kończących spór. Naprawdę gorąco zrobiło się podczas tworzenia części 11. Aby sceny wykańczania przeciwników były jak najbardziej wiarygodne i krwawe, deweloperzy przez miesiąc czerpali swoje inspiracje z filmików i zdjęć przedstawiających prawdziwe akty zbrodni i okrucieństwa.

O ile gracze są zachwyceni efektem końcowym, tak twórcy skończyli z objawami PTSD (zespołu stresu pourazowego). Podczas snu przemijały im sceny siekania, wieszania i mordowania, co poskutkowało unikaniem snu za wszelką cenę.

Poszkodowane osoby trafiły pod opiekę specjalistów i na niezbędną terapię. To nie pierwszy przypadek w samym NetherRealm Studios, kiedy nie określono dokładnie warunków procedur czy czerpania inspiracji i gdy kończy się to na rezygnacjach.

W Sytuacji ChatGPT chodziło o sortowanie przemocy, aby uniknąć jej eksplorowania. Widzicie jednak, że czasem chodziło o coś wręcz przeciwnego przy tworzeniu najbardziej krwawych gier. Pozostaje pytanie czy w obu przypadkach efekt jest równie wart włożonego wysiłku?

Dodaj komentarz